Klima aus dem Computer

Geschrieben am 11.05.2018 von HNF

In den 1940er-Jahren liefen die ersten Denkmaschinen mit Relais oder mit Röhren. Bald wurden sie eingesetzt, um die Rätsel von Wind und Wetter zu lösen. Der Ozeanograph Maik Thomas spürt diesen im Deutschen GeoForschungsZentrum GFZ in Potsdam nach. Am Mittwoch, dem 23. Mai, kommt er ins HNF und spricht dort über Computermodelle in der Klimaforschung.

Es ist ein fantastisches Bild. Tausende von Menschen sitzen in einer riesigen Halle in kreisförmigen Galerien, kurbeln Rechenmaschinen oder schieben Rechenstäbe. Ständig laufen Wetterdaten ein und werden an die Operateure verteilt. Diese bestimmen daraus die Entwicklung für die nächsten 24 Stunden und für die ganze Erde. Jede Galerie bearbeitet eine geographische Zone, die unteren die Südhalbkugel, die oberen den Norden. Ein Koordinator steuert den Fluss der Resultate, ermahnt langsame Rechner oder bremst zu schnelle.

So stellte sich der englische Meteorologe Lewis Richardson 1922 eine Wetterbericht-Fabrik vor. Seine Idee wurde natürlich nie realisiert. Bis weit ins 20. Jahrhundert hinein basierten Wetterprognosen auf Erfahrungswissen und dem Vergleich mit älteren Beobachtungen. Erst die Erfindung des Computers ermöglichte es, direkt aus Messdaten die wahrscheinliche Änderung von Temperatur, Wind und Luftdruck abzuleiten. 1947 skizzierte Konrad Zuse den Aufbau eines Wetterrechnungsdienstes mit der von ihm erfundenen Relaismaschine.

Vermutlich in den frühen Siebzigern entstand das Foto vom Control-Data-Computer im DWD (Bild Deutscher Wetterdienst Offenbach)

Schon 1946 erhielt der Computerpionier John von Neumann von der US-Marine Gelder für meteorologische Forschungen. Es verstrichen aber vier Jahre, bis der Elektronenrechner ENIAC die erste digitale Wettervorhersage produzierte. Verantwortlich dafür war der Meteorologe Jule Charney, ein Mitarbeiter John von Neumanns im Institute for Advanced Study in Princeton. Die Denkmaschine benötigte einschließlich der Programmierung 24 Stunden; sie wäre im Ernstfall sicher keine große Hilfe gewesen.

Schneller rechneten 1955 der Röhrencomputer BESK in Schweden und die IBM 701 des amerikanischen Wetteramts. Echte Pionierarbeit leistete 1966 der Deutsche Wetterdienst in Offenbach: eine CDC 3800 der Control Data Corporation gab zweimal täglich eine neue Prognose ab. Die Wochenschau von 1967 zeigt ab Minute 8:15 das Nebeneinander von alten und neuen Technologien, die ratternden Fernschreiber und die Satellitenfotos aus dem All. Eine gute Übersicht über die Fortschritte der Wetterrechnung liefert auch die Internetseite des englischen Met Office.

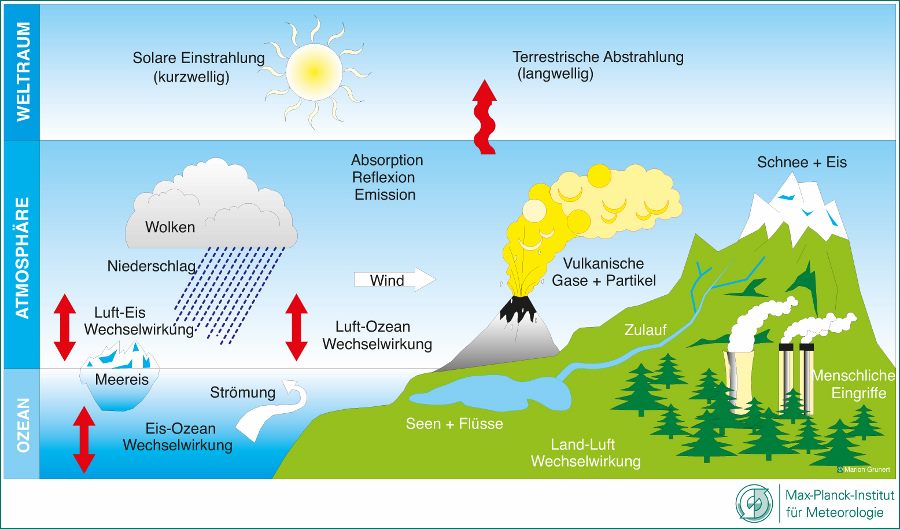

Das Klima ist die Fortsetzung des Wetters über längere Zeiten und größere Gebiete. Ein Klimamodell ist sozusagen die höhere Form des Wetterberichts und wagt – in der Regel mit Computerhilfe – langfristige Voraussagen für die Atmosphäre der gesamten Erde. Von besonderem Interesse sind dabei die künftigen Temperaturen und die Veränderungen des Meeresspiegels. Klimamodelle stützen sich auf Eingangswerte, vor allem auf die Strahlung der Sonne. Ein anderer wichtiger Input ist die Zusammensetzung der irdischen Lufthülle.

Das wohl erste Klimamodell schuf 1955 der amerikanische Wetterforscher Norman Phillips. Es erfasste schon den ganzen Planeten, ging aber nur einen Monat in die Zukunft. Phillips benutzte den im Institute für Advanced Study befindlichen IAS-Computer, den John von Neumann konstruiert hatte. 1966 erstellten der Japaner Syukuro Manabe und der Amerikaner Richard Wetherald eine Modellrechnung, die den Kohlendioxid-Anteil in der Atmosphäre berücksichtigte. Sie fanden, dass seine Verdoppelung die Lufttemperatur der Erde um zwei Grad erhöhen würde. Der Grund ist der berühmt-berüchtigte Treibhauseffekt.

Heutige Klimamodelle unterteilen die Lufthülle und die Meere unter ihr mit einem 3D-Gitter (Bild National Oceanic and Atmospheric Administration)

Die ersten Klimamodelle waren mathematisch anspruchsvoll, aber noch recht einfach gestrickt; es handelte sich im Wesentlichen um Strahlungsbilanzen der Lufthülle. In den 1970er-Jahren wurden die Ozeane und ihre Temperaturen aufgenommen; die Kontinente erschienen in grober Rasterung. Mit den Jahren verfeinerten sich die Modelle. Inzwischen werden die Atmosphäre und die Meere in ein räumliches Gitter unterteilt, das sich um den Globus zieht. Für jeden Abschnitt rechnet der Computer die physikalischen Vorgänge aus und führt die Resultate benachbarter Abschnitte zusammen.

Was dabei rauskommt, erzählt am Mittwoch, dem 23. Mai, Maik Thomas vom Deutschen GeoForschungsZentrum Potsdam im HNF. Er leitet die Sektion Erdsystem-Modellierung, sein Vortragstitel fragt Computermodelle in der Klimaforschung: Spiel- oder Werkzeug? Der Eintritt ist frei. Wer schon vorher mit dem Klima spielen möchte und etwas Zeit mitbringt, findet hier ein passendes Modell; Bedienungen und Erklärungen sind in deutscher Sprache. Eine englische Geschichte der Klimasimulation bietet diese Website an.